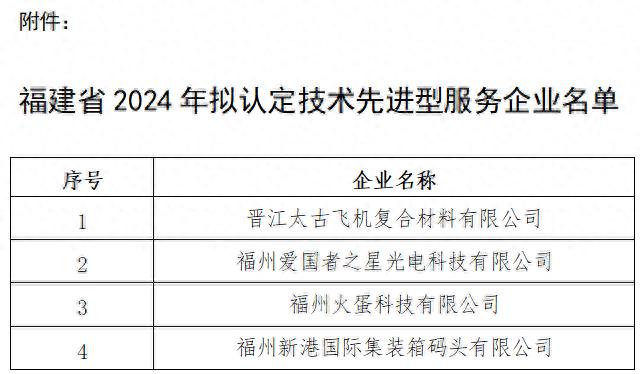

11月28-29日,为期两日的36氪WISE2024 商业之王大会于北京隆重落地,作为中国商业领域的全明星盛典,WISE大会今年已经是第十二届,在不断变化的时代里见证着中国商业的韧性与潜力。

2024,是有些模糊且变化多于稳定的一年。相比过去十年,大家的脚步正放缓,发展更加理性。2024,也是寻求新的经济动力的一年,新的产业变化对每个主体的适应性提出了更高的要求。今年WISE大会以Hard But Right Thing(正确的事)为主题,在2024,什么是正确的事,成为我们更想交流的话题。

算力,作为AI技术的核心驱动力,直接关系到AI应用的性能与效率。在全球化运营中,如何确保算力的充足与高效,如何应对AI 算力短缺、AI Infra稳定性不足等问题都是AI企业目前在全球化运营过程中亟需解决的问题。

GMI Cloud亚太区总裁King Cui 在大会现场分享了关于这些问题的解决方案。

(以下图片展示了King Cui演讲现场)

以下是King Cui演讲全文,略有删减:

朋友们大家下午好!我是来自GMI Cloud的King,今天分享一下全球布局情况下,AI企业如何在海外补齐短板,并且保证稳定性。

我做云计算已经十几年了,我将云计算的发展历程分为三个阶段——随着OpenAI的诞生和崛起,整个Cloud已经进入3.0时代,这个时候完全跟以前的云计算或者经典云计算时代是不一样的,企业计算需求更多是从CPU转向GPU,存储速度比以前高了很多倍,所以我们要做全新的形态。在这个背景下,我们成立了GMI Cloud,截至目前为止,刚刚创立了两年时间,总部在美国硅谷,目前主要是服务全球的AI企业和平台机构,我们在去年获得了英伟达认证的合作伙伴。

我们为什么能够在亚太区获得GPU分配权,我们除了跟英伟达合作之外,我们还跟GPU厂商保持比较好的合作,甚至他们也是我们的合作伙伴,我们的优势就是可以第一时间拿到最新版本的GPU,在亚太区拿到最新的服务器。比如说当下的H200,我们在今年8月份就开始对外提供云服务了,包括未来我们在明年的Q1会拿到GB200,也将会是亚太区第一个对外提供GB200云服务的NCP。我们目标是构建AI Cloud平台,我们是做GPU云服务生意,我们希望为AI企业提供稳定的AI基础设施。

目前我们在全球有10个数据中心,芯片主要以H100和H200为主。在今年十月份,我们刚刚宣布完成了新一轮融资,8200万美金,主要用于数据中心的建设,以及开拓新的H200 GPU的云服务。

我们的愿景是希望在AI云原生时代,能够成为“台积电”这样的企业,保持初心帮助合作伙伴提供比较稳定的AI Cloud,我们不会做大模型、应用,只专注地把我们的AI Cloud做好。

大家对GMI Cloud有了一个基础了解之后,下面我们就正式来聊一聊AI的出海,因为今天大家都在讲出海,但是也没有人讲为什么要出海,大家也觉得AI时代到来了,它相比以前的时代有什么区别?

从技术发展来讲,我们这代人非常幸运,我们经历了互联网时代、移动互联网时代、人工智能时代,从互联网到移动互联网,这两个时代基本上目前已经到了普惠点,如果中国还在做移动互联网创业的话大概率没有太大机会了,所以AI时代崛起比前两个时代更加迅猛,对社会和生产发展的影响更加巨大。这个时代的机会是非常明确的,所以我也是这样的时代驱使下离开了大厂,进入创业公司。

截止到今年8月份,全球有1700多个APP都是AI相关,其中中国有280个,出海相关比例高达30%,大概有92个APP。在PPT上,大家可以看到,我们列了排行榜前30的MAU,从今年1-9月份前十MAU增速已经环比超过了120%。

所有AI应用出海必然离不开的东西就是算力,AI三驾马车,数据、算法、算力,算力是基石,国内与海内的区别还是挺大的,海外供应商有很多不确定性,同时GPU时代的挑战性比传统CPU时代高很多,毕竟没有人做过超大规模的或者说十万卡以上GPU运维,但是CPU时代做过这样的事情,所以海外AI Infra的稳定性对于AI 出海企业来说,挑战是巨大的。

举一个例子,META前段时间发布了一个报告,他们用10000多张的H100,训练他们的Llama 405B大模型,总共54天的时间,出现了466次中断故障,其中有419次是预期外的,其中跟GPU相关得高达58%(280多次),CPU相关故障只有2次,这个数据对比可以看出,GPU跟CPU的稳定性挑战不是一个量级的。

整个的GPU稳定性其实就关系到我们研发的效率、时间成本、金钱,那下面就给大家汇报一下,整个GMI Cloud如何实现GPU集群高稳定性的。

首先从我们集群的架构层面来讲,我们完全是由自己自主研发的,我们从底层的GPU硬件,包括高速的GPU服务器、存储、网络,在PaaS层往上我们可以跟合作伙伴一起共建,比如说大模型,客户可以基于自己的大模型做研发,同时我们为广大的企业和个人开发者提供了开源大模型,一键部署到Cloud集群上面,并且我们有调优的服务。

(以下图片展示了GMI Cloud的产品)

(以下图片展示了GMI Cloud的网络设备)

(以下图片展示了GMI Cloud的存储设备)

在存储层面,我们为不同的业务场景提供了不同的存储介质,比如说数据备份场景,其实你不需要那么高的IOPS,如果做大模型训练的checkpoint存储或者做自动驾驶的数据读取,就需要很高的IOPS,所以可以根据业务场景需求,根据经济模型选择最适合你的存储类型。

而对于一个GPU集群来讲,如果想规模越大,稳定性越高,这个时候你需要非常强大的主动监控平台,于是我们研发了集群管理的监控体系,我们能够实现端到端检测,在整个平台上我们可以清晰化的看到在哪个节点出现网络的中断,快速定位到最根本的问题,让我们的伙伴去现场做一些实施,同时我们也支持在历史数据查询、追溯、报警监控和处理。

同时,在交付之前,为了保证集群交付质量,稳定性、可靠性,GMI Cloud还要经过两道工序,第一道工序就是英伟达NCP验证体系,因为我们是英伟达合作伙伴,我们要把设计方案先经过英伟达确认,然后实施,进行相应测试确保集群可用性,包括性能测试、压力测试。同时我们在交付客户之前工程师会做所有硬件、软件存储网络测试,并且会跑一些最基本的开源大模型,确保训练任务能够完好运行在我们的GPU上。可以说,通过英伟达质量认证体系,以及GMI自身交付验收体系,双重标准来确保交付集群是高稳定性集群。

另外值得一提的是,故障预演,出了问题之后如何快速定位、响应、解决问题,这个是很关键的。所以我们有两个方面——GMI Cloud跟IDC是深度合作伙伴,我们跟全球每个国家的IDC都有当地伙伴做本地化实施。同时我们跟GPU ODM厂商保持3-5%的备机备件,出现硬件故障,我们第一时间可以联系现场人员进行更换。GMI Cloud的保障体系能够做到快速发现、定位问题,快速恢复集群,确保对外的交付SLA是很高的SLA,目前全球范围内能够提供GPU集群SLA超过99%的不到,GMI Cloud算是其中之一。

讲完稳定性问题与解决方案,我们还是从AI infra选型的角度我们怎么选择云基础的合作伙伴。大家出海会根据业务进行选择,短期业务还是长期业务,也会根据场景进行选择。所以GMI Cloud会根据不同的客户需求,提供两种方式,如果你是一个长期租用的方式,我们推荐集群归你独享,长期使用。如果做“短期”的,就可以GMI Cloud端到端的解决方案,从底层定制化集群。关于GPU集群的配置,我们都会根据客户需求进行配置,你需要在哪个国家配置,我们就可以去哪个国家帮你进行配置和选择。

在软件层,GMI Cloud有自己的Cluster Engine,稳定性像CPU时代一样高的同时,付费方式更加灵活,用一两张卡,可以选择一两天,也可以选择连续用3年。同时,GMI Cloud还提供AI顾问服务,我们公司70%人员都是研发人员,其中一半是来自谷歌,他们以前做深度学习和HPC相关的事情,对整个AI算法和HPC高可用,拥有非常多的经验,这些经验GMI Cloud都可以跟企业客户进行共享。

在本次演讲的最后,给大家介绍两个案例,第一个案例是,一家大型互联网招聘企业在海外去构建私有GPU集群的过程中,GMI Cloud帮助他们从底层的IDC到GPU,全面进行构建,“开箱即用”、“拎包入住”,他们只需要聚焦在业务层面,而不需要关注底层运维和管理。

第二个案例是一个知名的直播平台,如大家所知,目前整个端到端大模型非常火,主播跟观众做连麦的时候,双方中英文对话需要能够实时做翻译,而这个过程中不需要先通过ASR再通过TTS,企业会直接使用跑在GMI Cloud上的端到端大模型。

以上是两种不同的案例,也我们两种不同的产品服务方式。

以上就是我今天的分享,从GMI Cloud的架构设计到整个体系,再到供应链保障维度做了分享,谢谢大家!更多信息请关注“GMI Cloud”公众号。

GMI Cloud